Tesla-Chef Elon Musk ist mal wieder optimistisch: Trotz des Desasters mit dem tödlichen Autopilot-Unfall im Mai 2016 sollen seine Elektroautos bis Ende 2017 in der Lage sein, autonom zu fahren. Ab sofort stattet er alle neu gebauten Teslas mit acht Kameras aus, die eigentliche Selbstfahr-Funktion soll dann, wie schon beim ersten Autopiloten, per Software-Update freigeschaltet werden.

Auch wenn sich die meisten etablierten Hersteller offiziell immer noch zurückhaltend äußern und ungern exakte Jahreszahlen veröffentlichen, ist in der autonomen Szene eine regelrechte Euphorie ausgebrochen. Jahrelang verfolgten die Autobauer den gemütlichen evolutionären Weg und verbesserten ihre Assistenzsysteme Schritt für Schritt. Daraus, so die gängige Meinung, ergäbe sich quasi von allein irgendwann mal das selbstfahrende Auto.

Künstliche Intelligenz beflügelt

Nach dem Vorbild von Google forschen jedoch inzwischen immer mehr Hersteller am revolutionären Ansatz, versuchen zu verstehen, was das selbstfahrende Auto braucht, um sich allein seinen Weg durch den Verkehr zu bahnen. Während Mercedes hierfür schon länger seinen kalifornischen Standort in Sunnyvale nutzt, gründete Audi im Sommer das Start-up Self-Driving-System (SDS). Vor wenigen Wochen gab auch BMW bekannt, ein Forschungszentrum mit angedockter Teststrecke im Raum München bauen zu wollen.

Grund der Euphorie: Für viele Probleme, die jahrelang als kaum beherrschbar galten, zeichnen sich Lösungen ab, die die Erwartungen der Entwickler teils deutlich übertreffen. So macht die kamerabasierte Umfeld-erkennung riesige Fortschritte, seit sie die Methoden künstlicher Intelligenz (KI) und des Deep Learning übernommen hat. Das Prinzip von Deep Learning: Statt eine Maschine explizit zu programmieren, was sie in welcher Situation zu tun hat, gibt man ihr Werkzeuge in die Hand, die Umgebung selbst zu strukturieren. Diese Werkzeuge sind per Computer nachgebildete neuronale Netzwerke, sie lernen also wie ein Kind, das sich vom Moment der Geburt an über die Sinnesorgane seine Welt erschließt.

Die Grundprinzipien der künstlichen Intelligenz existieren in der Theorie seit Jahrzehnten, doch erst innerhalb der letzten Jahre sind Computerprozessoren leistungsfähig genug geworden, mit den vielen Informationen klarzukommen. Ein selbstfahrendes Auto muss Gefahren und Hindernisse schließlich in Echtzeit erkennen, um darauf reagieren zu können.

Roboter müssen trainieren

Bevor ein Rechnerhirn in der Lage ist, auf Videos Fußgänger von Autos oder Bäumen zu unterscheiden, muss es im Vorfeld trainiert werden. Hierfür werden Bilder eingelesen, auf denen zuvor von Hand Objekte klassifiziert wurden. Hat der Rechner genug trainiert, sprich hat man ihm genug Fußgängerbilder gezeigt, ist er anschließend in der Lage, auf neuen Bildern selbstständig Menschen zu erkennen. Dabei gilt: je mehr Training, desto besser der Algorithmus.

Wie gut das Training inzwischen anschlägt, zeigt das Forschungsprojekt „Cityscape“ von Daimler, bei dem Videos von Straßenszenen in 50 verschiedenen Städten automatisiert ausgewertet wurden. Für den Computer galt es, 30 verschiedene Objektklassen zu unterscheiden (Fußgänger, Radfahrer, Autos, Häuser, Ampeln, Verkehrsschilder etc.) und farblich zu markieren. Seit 2015 ist die Erkennungsquote des KI-Systems höher als bei einer vom Menschen durchgeführten Auswertung. So werden selbst dann noch Fußgänger erkannt, wenn sie zum Großteil von parkenden Autos verdeckt werden.

Der Roboter lässt sich nicht in die Karten schauen

Das Besondere an den sich selbst programmierenden Algorithmen: Die Erkennung funktioniert so gut, dass sich die Cityscape-Entwickler teils gar nicht mehr erklären können, wie das System vorgeht, verrät Uwe Franke, der bei Daimler den Bereich Bilderkennung verantwortet. Besonders beeindruckt ist Franke von einer Straßenszene, in deren Hintergrund schemenhaft ein grauer Schleier zu erahnen ist, der alles andere als gefährlich wirkt. Doch bereits aus großem Abstand warnt der Algorithmus vor einem Gegenstand auf der Fahrbahn, aus der Nähe entpuppt sich dieser Gegenstand tatsächlich als Euro-Palette, die mitten auf der Straße liegt. An Zauberei grenzen Auswertungen von Nachtvideos, bei denen über ein paar verhuschte Pixel kreuzende Radfahrer erkannt werden.

Die KI-Forscher verdanken ihren Durchbruch unter anderem der Computerspielindustrie und deren Hunger nach immer besseren Grafikkarten. Eine Grafikkarte ist in der Lage, viele Rechenoperationen parallel durchzuführen, und eignet sich daher besser für Echtzeit-Bilderkennung als andere Prozessortypen. Hardware-Hersteller wie NVIDIA sind inzwischen zu wichtigen Automobilzulieferern aufgestiegen. Tesla setzt ab Dezember die neueste Hardware-Generation von NVIDIA ein, auch beim Flottenversuch von 100 autonomen Volvo im nächsten Jahr in Göteborg sollen die Sensordaten im neuen NVIDIA-Flaggschiff PX2 zusammenlaufen.

Obwohl Tesla die neuen Autopilot-Funktionen noch nicht freischaltet, läuft das System schon im Hintergrund und analysiert die Verkehrssituationen – es trainiert sich quasi selbst im Verborgenen. Damit profitiert Tesla von einem deutlich größeren Datenschatz als Hersteller, die nur mit ein paar Entwicklungsträgern durch die Gegend fahren.

Datenanalyse statt Intuition

Sorgen, dass Tesla damit uneinholbar voranpirscht, muss sich dennoch niemand machen. Das Gute an den KI-Algorithmen: Sie lassen sich auch über fremdes Bildmaterial trainieren. Daher kooperiert BMW mit Toyota und dem kalifornischen Start-up Nauto, das Daten für KI-Auswertungen generiert. Eine Kamera-Blackbox, die unter anderem in Taxis montiert wird, zeichnet Verkehrsszenen auf und füttert damit die Algorithmen.

In den Projekten geht es längst um mehr als um reine Objekterkennung. Den am Straßenrand stehenden Fußgänger zu erspähen, bringt zunächst wenig, da es sich nur um eine Momentaufnahme handelt. Das autonome Auto muss jedoch wissen, ob der Fußgänger auch in ein paar Sekunden noch dort steht oder auf die Straße getreten ist, in welche Richtung er läuft und ob er abgelenkt ist.

Um die Absicht von Fußgängern vorherzusagen, wertet Zulieferer Continental Körperhaltungen aus, um an Kopf-, Bein- oder Armhaltung den zeitlichen Verlauf von Bewegungen vorherzusagen. Dabei ist auch das Umfeld wichtig, erklärt KI-Entwickler Demetrio Aiello: Hält ein Omnibus an, steigt die Wahrscheinlichkeit, dass Fußgänger die Straße überqueren. Erst wenn die Bewegungen aller Verkehrsteilnehmer vorausberechnet werden, kann das Computerhirn im autonomen Auto seinen eigenen Fahrkorridor bestimmen.

Viel Sensorik nötig

Bei aller Freude um die Möglichkeiten der Bildauswertungen: Ohne zusätzliche Sensoren geht es nicht. Während Tesla die acht Kameras lediglich um einen einzigen Radarsensor an der Front ergänzt, setzen deutsche Hersteller auf bis zu sechs Radarsensoren unterschiedlicher Reichweiten. Radarsensoren arbeiten mit elektromagnetischen Wellen, sie behalten ihr Umfeld also auch dann im Blick, wenn Kameras nichts mehr sehen. Zudem sind sie in der Lage, sehr schnell und präzise Geschwindigkeitsunterschiede zu anderen Verkehrsteilnehmern zu bestimmen. Dafür zeichnen sie jedoch ein sehr grobes Bild, können die Größe von Objekten schlecht unterscheiden. Hier schlägt die Stunde von Laserscannern, die ein wesentlich feineres 3-D-Bild ihrer Umgebung zeichnen.

Bei solchen Scannern werden Laserstrahlen über ein Spiegelsystem ausgerichtet, um die Umgebung Schicht für Schicht abzutasten. Geeignete Laserscanner kosteten bis vor Kurzem noch viele Tausend Euro und damit zu viel für Auto-Einsätze. Zulieferer Valeo hat jedoch einen abgespeckten Laser entwickelt, der nur noch im dreistelligen Eurobereich liegen soll und 2017 im nächsten Audi A8 debütiert.

Günstige Laserscanner

Doch es geht noch günstiger: Chip-Hersteller Infineon übernahm Anfang November die Firma Innoluce, die einen Laserscanner entwickelt hat, der auf bewegliche Spiegel und damit komplett auf sensible mechanische Bauteile verzichtet. Die auf Halbleitern basierenden Scanner sollen wesentlich kompakter ausfallen als bisher und so günstig werden, dass sie auch in Kleinwagen eingebaut werden können.

Selbst für Szenarien, die bis vor Kurzem noch als unbeherrschbar galten, zeichnen sich Lösungsansätze ab: Autonome Fahrzeuge bestimmen ihre Position nur zum Teil über die GPS-Antenne, da deren Daten nur für eine Genauigkeit von fünf bis zehn Metern reicht. Ein selbstfahrendes Auto muss sich jedoch auf etwa 20 Zentimeter exakt positionieren.

Um die GPS-Genauigkeit zu verbessern, nutzt es seine Kameras nicht nur für die Erkennung anderer Verkehrsteilnehmer, sondern auch um sich an festen Hindernissen wie Bordsteinkanten, Ampelmasten oder Gebäuden zu orientieren. In hochauflösenden Karten werden daher solche Orientierungshilfen verzeichnet, auch Fahrbahnmarkierungen dienen der Feinpositionierung. Unter ungünstigen Bedingungen wie Schneefall sind die Striche jedoch nicht erkennbar, Kollege Roboter verliert daher im Winter die Orientierung. Dachte man bisher.

Bei einem Projekt des Massachusetts Institute of Technology (MIT) gelang es Forschern jedoch, ein Auto ganz ohne Kameras zu positionieren. Die Wissenschaftler scannten hierfür zunächst auf einer Teststrecke per Radar den Boden und erstellten so ein charakteristisches Profil des Untergrunds. Anschließend konnte sich der Versuchsträger anhand der unterschiedlichen Gesteinsschichten und Härtegrade im Boden auf vier Zentimeter genau orten. Das Projekt befindet sich jedoch noch im frühen Forschungsstadium, ob und wann es sich einmal fürs automatisierte Fahren einsetzen lässt, ist derzeit noch nicht abschätzbar.

Gesetzgebung als wichtiger Faktor für die Entwicklung

Wann wir vollautonom fahren, hängt jedoch nicht nur von den Ideen der Ingenieure ab, sondern auch vom Gesetzgeber. Denn Stand heute sind alle Fahrhilfen, die über eine Assistenzfunktion hinausgehen, nicht zulassungsfähig. Die Gesetzeslage ändert sich jedoch gerade, schließlich will Verkehrsminister Alexander Dobrindt Motor des autonomen Fahrens werden. So beschloss der Bundestag Ende September ein Gesetz, das technische Fahrsysteme erlaubt, sofern der Mensch jederzeit in der Lage ist, ins Steuer zu greifen und den Roboter zu überstimmen. Kommt die Technik an ihre Grenzen, muss der Fahrer auf Zuruf innerhalb einer Übergabezeit (diskutiert werden zehn Sekunden) in der Lage sein zu übernehmen. Schlafen legen darf er sich daher nicht, ein Blick aufs Smartphone ist jedoch allemal drin und dann sogar erstmals völlig legal. Auch eine Blackbox, die aufzeichnet, wer wann gefahren ist, sieht das Gesetz vor.

Welcher Hersteller als erster von den neuen Freiheiten Gebrauch macht, dürfte spannend werden. Neben Tesla liegt Audi gut im Rennen, die den nächsten A8 mit einem Autobahnpiloten ausstatten wollen, der bis zu einer gewissen Geschwindigkeit ohne menschliche Aufsicht auskommen soll. Das neue Topmodell kommt zur IAA im September 2017.

Künstliche Intelligenz: Riesenfortschritte bei Bilderkennung

In einem Forschungsprojekt von Daimler muss ein Algorithmus Innenstadtszenen analysieren und 30 verschiedene Objektarten erkennen. Inzwischen liegt die Trefferquote beim Rechner höher als beim Menschen. Zudem analysiert der Rechner 20 Bilder pro Sekunde und ermüdet selbst nach stundenlanger Fahrt nicht. Möglich wurden die Fortschritte durch die Methoden der künstlichen Intelligenz, bei der sich Kollege Roboter selbst trainiert, indem er große Mengen an Bildern auswertet.

Komplexe Verkehrssituationen verstehen lernen

Fußgänger einfach nur zu erkennen reicht längst noch nicht, das selbstfahrende Auto muss auch verstehen, was im Umfeld passiert: Steht die Person oder geht sie? Wenn ja, in welche Richtung? Continental verfeinert deshalb ein Verfahren, das die Absicht von Menschen anhand der Körperhaltung berechnet. Hierfür wird ein vereinfachtes Skelett über die erkannten Personen gelegt. Neben Bein-, Arm- oder Kopfhaltung gilt es, das Umfeld zu berücksichtigen. Ein Zebrastreifen erhöht die Wahrscheinlichkeit, dass eine Person auf die Straße tritt. Die Maschine soll sich verhalten wie ein geübter Autofahrer, der beispielsweise intuitiv auf die Bremse tritt, wenn ein Ball auf die Straße rollt. Auch hier gilt: Mit je mehr kritischen Situationen der Rechner trainiert wurde, desto besser werden die Algorithmen.

Heutige Navigationskarten sind für Roboterautos viel zu ungenau

Über das satellitenbasierte GPS-System können sich Autos derzeit gerade einmal auf fünf bis zehn Meter genau positionieren. Autonome Fahrzeuge benötigen jedoch für viele Fahrmanöver eine Genauigkeit von 20 Zentimetern. Solch eine Präzision lässt sich über die ohnehin vorhandenen Sensoren herstellen: Kamera, Laserscanner und Radar halten Ausschau nach festen Objekten wie Bordsteinkanten, Ampelmasten, Leitplanken oder Gebäuden. Diese wiederum müssen in einer hochgenauen Karte verzeichnet sein. Weiß ein Auto beispielsweise, dass 3,50 Meter vor und 2,80 Meter rechts neben der Kreuzung ein Ampelmast steht, kann es sich in dessen Nähe zentimetergenau positionieren. Daher vermessen Kartenhersteller derzeit die Welt neu und reichern ihre Karten um die festen Orientierungshilfen an. Audi, BMW und Mercedes haben hierfür bereits 2015 den ehemals zu Nokia gehörenden Kartendienst Here aufgekauft, der momentan zur Datenbank für hochpräzise Karten ausgebaut wird.

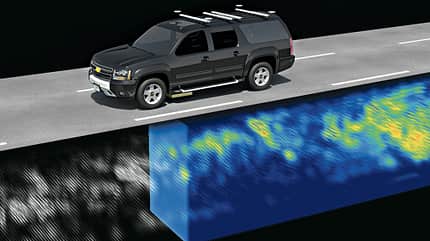

Untergrundradar hilft bei der Orientierung

Damit sich das selbstfahrende Auto zurechtfindet, müssen sich seine Kameras an Fahrbahnmarkierungen oder sonstigen Objekten in der Umgebung orientieren. Blöd nur, wenn die unter einer Schneedecke verborgen liegen. Winter mögen die Roboterautos daher gar nicht. Doch dies könnte sich ändern: Ein Forscherteam des Massachusetts Institute of Technology entwickelte ein Bodenradar, das den Bereich unter dem Asphalt drei Meter tief scannt. Anhand des charakteristischen Untergrundprofils konnten sich Fahrzeuge anschließend auf vier Zentimeter genau positionieren – ganz ohne Kameras. Ob sich die Methode durchsetzt, steht jedoch noch nicht fest, da zunächst sämtliche Straßen gescannt werden müssten. Winter bleibt jedoch auch noch aus einem anderen Grund heikel: So lässt sich der Haftwert für die Reifen derzeit kaum voraussehen. Dies ist für die Wahl der Geschwindigkeit jedoch wichtig.

Aus Unfall gelernt?

Tesla rüstet seinen Autopiloten mit acht statt wie bisher mit einer Kamera aus. Die übrige Sensorik fällt jedoch nach wie vor bescheiden aus. Mit selbstbewussten Versprechungen hat Tesla der autonomen Szene schon einmal geschadet: Die Elektroauto-Pioniere vermarkteten ihr Assistenzsystem als Autopilot, was viele Kunden wörtlich nahmen – mit den bekannten Konsequenzen: Weltweit gab es bereits zahlreiche leichtere und schwerere Unfälle, im Mai kam in Florida gar ein Tesla- Fahrer ums Leben, als der Autopilot einen kreuzenden Lkw nicht erkannte. Jetzt bessern die Amerikaner die schlichte Sensorik ihrer Autos nach: Statt einer kommen ab sofort acht Kameras zum Einsatz, deren Bilder von einem leistungsfähigen Grafikprozessor von NVIDIA ausgewertet werden. Das System läuft anfangs nur im Hintergrund und soll bis Ende 2017 per Software- Update freigeschaltet werden. Acht Kameras klingt nach viel, darüber hinaus belässt es Tesla allerdings bei einem einzigen Radarsensor, Laserscanner sind gar nicht vorgesehen. In Oberklasse-Autos wie der Mercedes S-Klasse werden schon heute sechs Radarsensoren eingebaut, zukünftige Systeme sollen zudem mit Laserscannern vorn und hinten ausgestattet werden. Nach Ansicht vieler Experten schützt erst das Miteinander verschiedener Sensortypen vor Erkennungsfehlern. Daher bleibt zu hoffen, dass Tesla seine Kunden nicht noch einmal gefährdet – und der autonomen Szene weiteren Schaden zufügt.

Fazit

Um das Thema künstliche Intelligenz wird gerade ein Riesen-Bohei gemacht, schon warnen wieder die Ersten vor zu großen Erwartungen. Das Verkehrsgeschehen zu analysieren scheint jedoch ein perfektes Betätigungsfeld für selbstlernende Maschinen zu sein: In schwer durchschaubaren Vorgängen wiederkehrende Bewegungsmuster zu entdecken und daraus eigenes Handeln abzuleiten, ist die Stärke dieser Technik. Die funktioniert teils schon so gut, dass sich der Mensch gar nicht mehr erklären kann, wie Kollege Roboter vorgeht. Auch wenn es darüber hinaus noch viele Probleme zu lösen gilt: Der autonomen Szene hat die KI einen enormen Auftrieb gegeben.